目录

AI Repos

1、smartpdfs

SmartPDFs 是一款利用 Llama 3.3 模型在 Together AI 上进行推理的工具,能够即时总结 PDF 内容并进行分段。该应用采用 Next.js、Tailwind、TypeScript、Prisma ORM、Neon (Postgres)、Helicone (可选)、Plausible 和 S3 等技术栈构建。用户可以通过简单的步骤克隆代码、配置环境变量并运行,即可在本地使用。其未来计划包括增加速率限制、集成 OCR、优化用户界面、改进总结质量、提供演示 PDF 以及增加反馈系统。SmartPDFs 旨在为用户提供便捷高效的 PDF 内容处理体验。

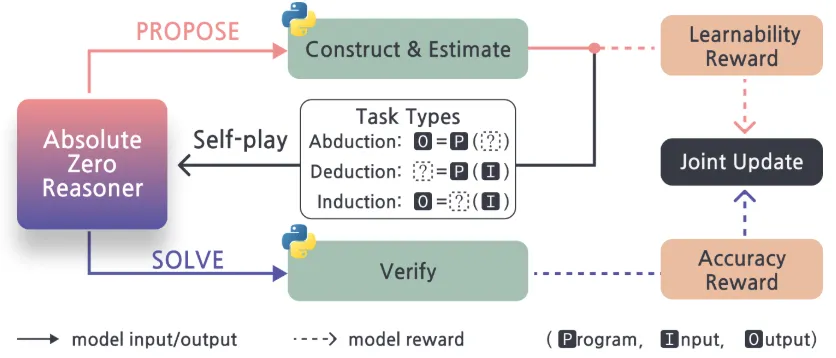

2、Absolute-Zero-Reasoner

Absolute Zero 是一种新颖的推理方法,核心在于重复迭代的“PROPOSE”和“SOLVE”两个步骤。模型首先自主生成包括溯因、演绎和归纳在内的推理任务,并通过 Python 执行验证其有效性并赋予可学习性奖励。随后,模型尝试解决这些自生成任务,并通过 Python 执行验证答案的准确性并获得准确性奖励。借助 TRR++,模型在这两个阶段不断改进,形成一个自我进化的循环,从而在没有任何外部训练数据的情况下增强推理能力。项目已发布,包含项目主页、论文、模型、代码和实验记录,并计划发布训练和评估代码。

3、arxiv_daily_aigc

Arxiv Daily AIGC 是一个自动化项目,每日从 arXiv 的 cs.CV 领域抓取最新论文,利用 AI (通过 OpenRouter API) 智能过滤与图像、视频和多模态生成相关的论文,并评估其价值。项目将过滤后的论文信息保存为 JSON 文件,并基于 JSON 数据生成美观的 HTML 每日报告,同时更新主页。整个流程,包括每日定时抓取、过滤、生成和部署到 GitHub Pages,均通过 GitHub Actions 自动完成。该项目采用 Python、HTML、TailwindCSS、JavaScript 等技术栈。

AI News

1、Mistral 发布 Medium 3 模型:高性能低成本,赋能企业应用

Mistral 推出了其 3 系列的中等规模模型 Medium 3,该模型在性能上表现卓越,多项基准测试中达到或超过 Anthropic Claude Sonnet 3.7 的 90%,并超越了 Llama4Maverick 和 Cohere Command A 等模型。Medium 3 的运营成本极具优势,每百万 Token 的输出成本仅为 0.4 美元,远低于行业平均水平。该模型在编程、STEM 和多模态理解等专业领域表现出色,并提供持续预训练和完全微调功能,方便企业集成。Mistral 还预告了更大规模的 Large 模型即将发布。

2、Netflix 全新主页上线,携手 OpenAI 引入智能搜索

Netflix 宣布推出全面更新的主页设计,旨在提升用户搜索电视剧和电影的便捷性。新主页不仅优化了电视屏幕界面,还新增了竖版视频流功能,更适合移动设备观看和分享。此次更新的亮点是由 OpenAI 支持的智能搜索功能,用户可以使用特定短语进行内容搜索,系统将更智能地推荐相关影片。Netflix 希望通过更友好的界面和个性化推荐,提升用户满意度,并在激烈的流媒体竞争中保持优势。新功能将在未来几个月内逐步向全球会员推送。

3、Gemini 2.0 Flash 图像生成升级:视觉质量与文字清晰度大幅提升

Google 近日宣布升级了 Gemini 2.0 Flash 的图像生成功能,用户可通过 Google AI Studio 体验最新模型。本次升级主要体现在三个方面:显著提升了图像的视觉质量,使其更自然、细节更丰富;更精准地渲染文字,解决了以往生成图像中文字扭曲不清的问题;并优化了内容安全机制,减少不必要的拦截,提高了生成效率和可用性。此次更新标志着 Gemini 模型在多模态生成能力上的持续进步,为 AI 创作者提供了更实用精确的图像生成工具。

4、Anthropic 推出 Claude 网络搜索 API,赋能实时信息检索

Anthropic 发布了 Claude 的全新网络搜索 API,开发者现在可以通过该 API 使 Claude 能够访问最新的网络信息,从而增强其知识库并提供实时的现实数据。Claude 能够进行多次渐进式搜索,汇总全面的答案并引用信息来源。此举正值传统搜索引擎市场份额下降之际,AI 搜索的兴起正在挑战谷歌的主导地位。Anthropic 的技术方案通过复杂的决策层生成针对性搜索查询,模拟人类研究过程,为用户提供更简洁且有上下文的答案。该 API 的推出预示着信息获取方式向更整合、更对话的模式演变。

本文作者:junglehxj

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!